Linas Suche – ein multisensorischer interaktiver Audiowalk

Überblick

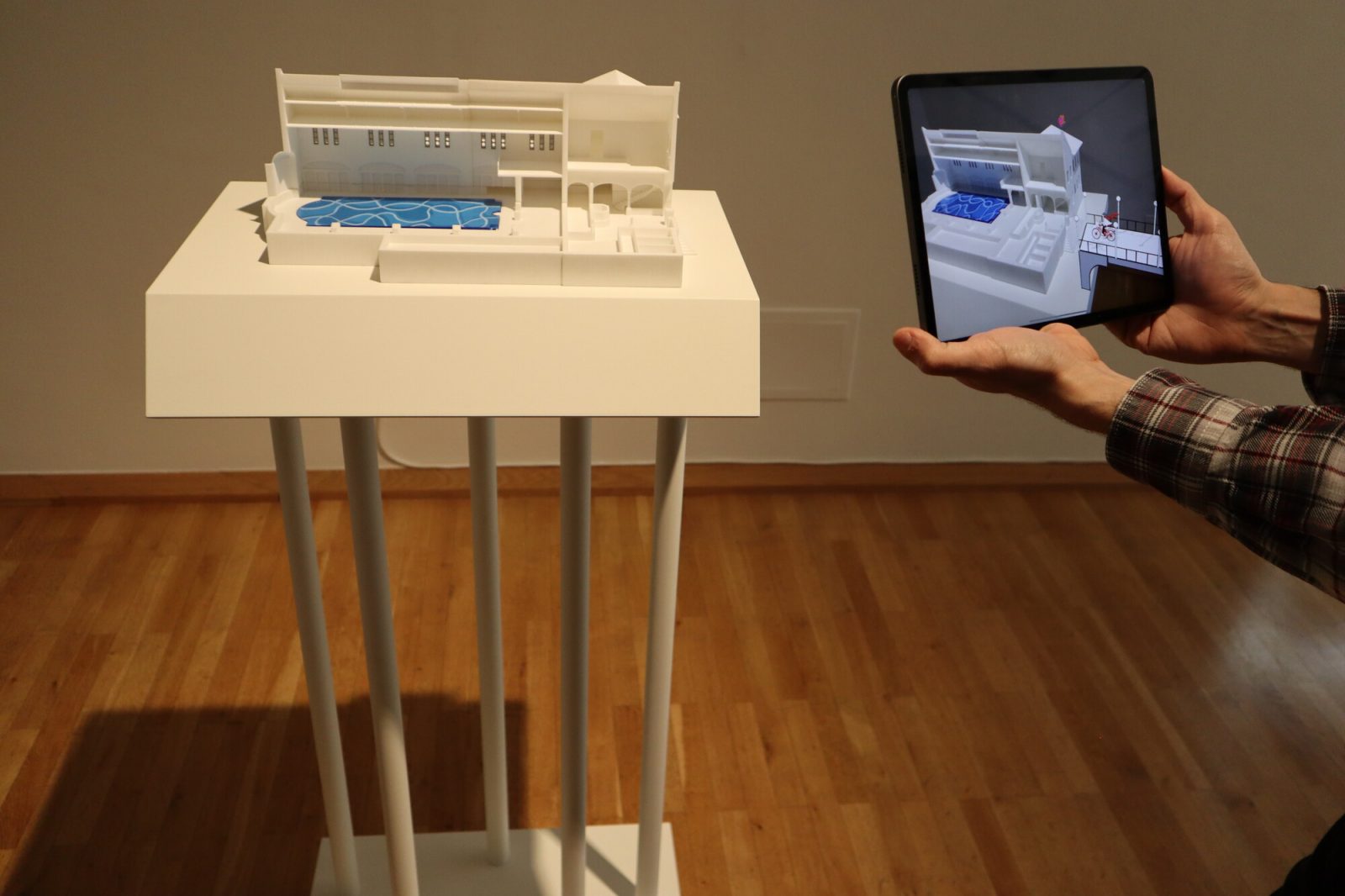

Ausgangspunkt des immersiven Audiowalks ist das bei Besucher*innen und Stadtführungen gleichermaßen sehr populäre Stadtmodell, das die Universitätsstadt Gießen vor ihrer Zerstörung im zweiten Weltkrieg um das Jahr 1935 zeigt. Dieses vielschichtige Objekt wurde nicht nur physisch wie auch digital innovativ erweitert, sondern darüber hinaus in einen multisensorischen Rundgang eingebettet, der die Besucher*innen auf spielerische, aktivierende und sinnliche Weise durch digitale Formate in die erzählerische Welt der Stadtgeschichte hineinzieht und sie partizipieren lässt.

Ausgestattet mit Kopfhörern und einem Tablet können die Besucher*innen zwischen vier fiktiven Charakteren auswählen, die sich nicht nur charakterlich stark voneinander unterscheiden, sondern jeweils einen Themenschwerpunkt durch ihre individuelle Biografie vorgeben, welchem man durch die gesamte Dauerausstellung folgt. An bestimmten Stationen wird die Geschichte an Museumsobjekte geknüpft und mit Augmented Reality wie auch partizipatorischen Elementen erweitert. Eine der auswählbaren Charaktere wurde im Zuge des museum4punkt0-Verbundprojektes realisiert und in die Testphase gebracht.

Bibliographische Angaben

- Institution

- Oberhessisches Museum Gießen

- Teilprojekt

- imp – immersiv partizipieren. Virtuelles Storytelling im Museum

- Autor*innen

- Anna Atalkin, Mário Jorge Alves, Marie Gloger, Andreas Haase, Amalka Hermann, Linn Mertgen, Julia Schopferer, Katharina Weick-Joch

- Veröffentlicht

- 17.07.2023

- Lizenz der Publikation

- CC BY 4.0

- Kontakt

- Oberhessisches Museum Gießen

Oberhessisches Museum Gießen

(0641) 360 1331

museum@giessen.de

Entwicklung

Für das Team des Oberhessischen Museums Gießen war von Anfang an völlig klar, dass die Grundprinzipien in der musealen Vermittlung beibehalten werden und das Einsetzen von neuen Technologien diese erweitern, aber nicht ersetzen soll. Das reale Museumsobjekt sollte weiterhin im Fokus stehen, wodurch sich in den Überlegungen eine Virtual Reality (VR) Anwendung schon recht schnell ausschloss, denn das physische Objekt spielt in der künstlich geschaffenen Welt keine Rolle mehr. Dahingegen verfügte die hybride Technologieanwendung der Augmented Reality (AR) über die Möglichkeit, beides zu verbinden: Das physische Museumsobjekt mit der dazugehörigen künstlich geschaffenen, virtuellen Geschichte.

Inhaltliches Konzept

Die neue ICOM-Museumsdefinition betont die Bedeutung von Vergnügen, spannenden Geschichten und interaktiven Erlebnissen, um Besucher*innen anzusprechen und eine persönliche Verbindung zu den Exponat-Geschichten herzustellen.

Eine Methode, um interaktive Erlebnisse zu schaffen, ist das (virtuelle) Storytelling mit einem dramaturgischen Spannungsbogen, basierend auf Dan Harmons „Story Circle“. Hierbei ist es wichtig, die Zielgruppe und das Oberthema der Geschichte festzulegen und die Objekte gründlich zu untersuchen. Die Ergebnisse der Recherche werden in den Story Circle integriert, indem passende Unterthemen und Objekte den Stationen zugeordnet werden, um die Geschichte und Biografie der Protagonist*innen zu verbinden. Bei der Planung technischer Anwendungen wie AR ist ausreichend Bildmaterial erforderlich und die Verortung der Objekte im realen oder virtuellen Raum muss berücksichtigt werden.

Als Museum wollen wir eine breite Zielgruppe ansprechen, indem wir Objekte und Geschichten an die Lebenswirklichkeit verschiedener Gruppen anknüpfen und aktuelle Themen und Debatten einbeziehen, um wechselnde Interessen und subjektive Perspektiven zu berücksichtigen.

Durch die Verknüpfung von musealen Objekten und Themen mit der Geschichte der Protagonist*innen im Story Circle entsteht eine Grundlage für eine gute Storyline. In unserem Projekt wurde der Story Circle genutzt, um eine funktionierende Storyline für den Audiowalk zu entwickeln, die eng mit den Museumsobjekten verbunden ist. Diese Geschichte wurde mithilfe von AR-Technologie in einen spannenden, multisensorisch-interaktiven Audiowalk verwandelt, in dessen Rahmen ein Stadtmodell sowie weitere analoge Objekte digital erweitert wurden. Aus der intensiven Zusammenarbeit des Teams, bestehend aus Drehbuchautorin Jenny Alten, Illustratorin Jelena Milunovic, Programmierer Luka Tillinger und dem OHM-Team unter der maßgeblichen Beteiligung von Mário Jorge Alves, der die relevanten historischen Daten recherchierte, um der fiktiven Narration mehr Kredibilität zu verleihen, heraus entstand Stück für Stück die Geschichte von „Linas Suche“.

Technisches Konzept

Die Augmented Reality (AR) ist eine aufregende Technologie, die unsere Wahrnehmung der realen Welt erweitert und digitale Inhalte nahtlos in unsere Umgebung integriert. Durch den Einsatz von AR können virtuelle Objekte, Informationen und Bilder in Echtzeit auf unsere physische Umgebung projiziert werden.

Im Fokus der AR-Anwendung „Linas Suche“ steht das Gießener Stadtmodell von 1935, welches später auch den Ausgangspunkt für einen Rundgang durch die neu konzipierte Dauerausstellung des Oberhessischen Museums bilden soll. Im „Digitallabor“ des OHM-Standortes „Altes Schloss“ werden dieses und zwei weitere Objekte – ein Objekt aus der Dauerausstellung sowie ein eigens für „Linas Suche“ angefertigtes Modell des heute nicht mehr existierenden Gießener Stadtbades – durch animierte Illustrationen digital erweitert bzw. „zum Leben erweckt“. Doch wie funktioniert eigentlich die Verortung der digitalen Animationen im analogen Raum?

Zunächst erfasst das AR-Gerät (in unserem Fall: das iPad) die reale Umgebung mithilfe verschiedener Technologien wie Kameras, Sensoren und GPS. Diese Informationen werden verwendet, um die genaue Position und Ausrichtung des Geräts im Raum zu bestimmen. Um virtuelle Inhalte in die reale Welt zu projizieren, muss das AR-Gerät Referenzpunkte oder Marker erkennen. Dies kann entweder durch das Erkennen spezieller Marker oder durch die Erkennung von Oberflächen wie Wänden, Böden oder eben bspw. ausgestellten Exponaten erfolgen. Sobald das AR-Gerät die Umgebung erfasst und Referenzpunkte erkannt hat, können virtuelle Inhalte, wie 3D-Modelle, Bilder oder Informationen, in Echtzeit überlagert oder in den Raum projiziert werden. Diese virtuellen Inhalte werden, basierend auf der Position und Ausrichtung des AR-Geräts, korrekt platziert, um eine nahtlose Integration mit der realen Welt zu ermöglichen. Benutzer*innen können mit den virtuellen Inhalten interagieren, entweder durch Berührung des Bildschirms oder durch Gestensteuerung. Dies ermöglicht es ihnen, virtuelle Objekte zu bewegen, Informationen abzurufen oder Aktionen durchzuführen.

In unserem Fall wird die Geschichte der Protagonistin „Lina“, eine der auswählbaren Personen aus einem Pool an diversen Charakteren, „bebildert“ und dadurch nicht nur in der klassischen Funktion eines Audiowalks hörbar, sondern multisensorisch erlebbar, „lebendig“ gemacht.

Implementierung und Inbetriebnahme

Bei der technischen Implementierung des zuvor entwickelten Konzeptes mussten wir uns einer Vielzahl von Herausforderungen stellen. Um virtuelle Objekte korrekt in der realen Welt zu platzieren, ist präzises Tracking und eine genaue Kalibrierung erforderlich. Das Tracking von Objekten oder der Benutzerposition kann technisch anspruchsvoll sein und verschiedene Ansätze erfordern. Schwierigkeiten können bei unstrukturierten oder komplexen Umgebungen auftreten, beispielsweise bei schlechter Beleuchtung, reflektierenden Oberflächen oder beweglichen Objekten. Es hat gedauert, bis wir herausgefunden haben, welche Beleuchtungssituation für unser Setting die optimale ist und wie wir sie möglichst unverändert halten – nämlich durch möglichst wenig Tages- und mehr künstliches Licht im Raum. Wir haben die exakte Position von Objekten mit Tape auf dem Fußboden markiert, damit diese, falls jemand bspw. gegen sie stößt oder sie auf sonst irgendeine Art und Weise verschoben werden, an ihren Ursprungsort zurückgebracht werden können, um Fehler beim Tracking zu vermeiden. Darüber hinaus benötigen AR-Anwendungen eine erhebliche Rechenleistung und Ressourcen, um Echtzeit-Tracking, Rendering und Darstellung der virtuellen Inhalte zu ermöglichen. Die Optimierung von Performance und Energieeffizienz ist entscheidend, um ein flüssiges und ansprechendes AR-Erlebnis zu gewährleisten. Die Aktualisierung und Wartung von AR-Inhalten kann ebenfalls eine Herausforderung darstellen, insbesondere wenn Änderungen an der physischen Umgebung oder am Tracking erforderlich sind. Unser Programmierer Luka Tillinger hat hier ganze Arbeit geleistet, ohne sein technisches Know-How hätten wir die Anwendung weder realisieren noch implementieren können. Im Endergebnis sind es nun 6 iPads, auf denen die Anwendung über die Software „Unity“ läuft.

Der Entwicklungsprozess der Anwendung hat mehrere Schritte umfasst. Der erste Schritt bestand darin, eine Idee für die AR-Anwendung zu entwickeln und ein Konzept zu erstellen. Dies beinhaltete die Definition des Anwendungszwecks, der Zielgruppe und der gewünschten Funktionen. Es ist wichtig, eine klare Vision für die Anwendung zu haben, um einen guten Ausgangspunkt für die Entwicklung zu schaffen (mehr dazu unter „Entwicklung / Inhaltliches Konzept“). Nachdem das Konzept erstellt wurde, folgt die Phase des Designs und der Erstellung von Prototypen. Hier werden die Benutzer*innenoberfläche, die Interaktionselemente und das visuelle Erscheinungsbild der Anwendung entworfen. Es werden auch erste Prototypen erstellt, um das Benutzer*innenerlebnis zu testen und zu verfeinern.

Der Kern der AR-Anwendungsentwicklung beinhaltet die Integration von AR-Technologien, wie beispielsweise die Erkennung und Verfolgung von Markern, die Platzierung von virtuellen Objekten in der realen Welt und die Interaktion mit ihnen. Zudem müssen die Inhalte, die in der AR-Anwendung angezeigt werden sollen, erstellt oder importiert werden, wie 3D-Modelle, Animationen oder Audiodateien. Sobald die AR-Anwendung entwickelt wurde, ist es wichtig, umfangreiche Tests durchzuführen, um Fehler zu finden und die Leistung zu optimieren. Dabei werden verschiedene Szenarien simuliert und die Anwendung auf verschiedenen Geräten getestet, um sicherzustellen, dass sie reibungslos funktioniert und eine gute Benutzer*innenerfahrung bietet. Die Entwicklung einer AR-Anwendung erfordert ein interdisziplinäres Team von Entwickler*innen (bei uns: Programmierer Luka Tillinger), Designer*innen / 3D-Künstler*innen (Jelena Milunovic) und Content-Ersteller*innen (bei uns: das OHM, STUDIO NEUE MUSEEN, Drehbuchautorin Jenny Alten). Es ist ein iterativer Prozess, bei dem verschiedene Phasen mehrmals durchlaufen werden können, um das bestmögliche Ergebnis zu erzielen.

Die Einführung von AR-Anwendungen erfordert auch eine Schulung der Benutzer*innen, um sie mit der neuen Technologie vertraut zu machen und mögliche Bedenken oder Widerstände zu überwinden. Auch hier haben wir auf Menschen vertraut, die mehr Erfahrung als wir in Fragen des Usability-Testings sowie der Vermittlung von technischem Know-How haben und haben Johannes Schmid und Nils Seipel vom Gießener „Makerspace“ eingeladen, um uns mit der Funktionsweise und Nutzung der Anwendung vertraut zu machen (mehr dazu unter „Besucherforschung und Usability Tests“).

Bereitstellung der Nachnutzung

Die Quelldateien mitsamt technischer Dokumentation steht anderen Kultureinrichtungen zum Download und zur individuellen Anpassung auf GitHub zur Verfügung. Weitere Elemente der Nachnutzung finden Sie im Anhang dieser Publikation.

Besucherforschung und Usability Tests

Für den Usability-Test haben wir einen guten und vor allem lokalen Partner im „Makerspace Gießen“ finden können. Der Makerspace ist ein von Johannes Schmid und Nils Seipel initiiertes Digital-Bildungszentrum, das die Nutzung neuer Technologien vermittelt und somit zugänglich macht. Da für die generelle Nutzung des immersiven Audiowalks Betreuer*innen nötig sind, ist der Usability-Test in fünf Schritten mit diesen durchgeführt worden.

Im ersten Schritt wird die Anwendung in einem Praxisdurchlauf auf ihre Benutzer*innenfreundlichkeit hin geprüft. Ein stichwortartiges Testprotokoll mit der dazugehörigen Analyse dienen dann als Grundlage für die weiteren Schritte.

Daraufhin wurde anhand eines dynamischen Rollenspieles, in dem unterschiedlichste User*innen-Charaktere auftreten, um auf unvorhergesehene Situationen, Problemaufkommen und dergleichen vorbereitet zu sein und einen reibungslosen Ablauf der Anwendung zu gewährleisten. Hierbei war das Ergebnis, eine Liste von Schlüsselakteur*innen zu erstellen und zu identifizieren, um auf deren Verhaltensgrundlage eine Funktionsbeschreibung der Anwendung zu generieren. Die Funktionsbeschreibung diente daraufhin als Grundlage für ein Praxistest-Handbuch. Dieses Tutorial wird dann nochmals auf eine breite Usablity und allgemeine Verständlichkeit hin geprüft. Im letzten Schritt der Usability-Prüfung sollte eine Vorbereitung und eine Durchführung der Betreuer*innen mittels einer Onboarding-Veranstaltung für die AR-Anwendung praxisnah durchgeführt werden. Mit den gemachten Praxiserfahrungen stand nun der Zusammenstellung von Informationen zu besonders häufig gestellten Fragen, häufig auftretenden Problemen – den FAQs – nichts mehr im Wege. Die Betreuer*innen der Anwendung wurden also nicht nur in die Handhabung eingeführt, sie waren auch Teilbestand der Usability-Entwicklung und der dazugehörigen Zusammenstellung der FAQs.

Evaluierung

Im Testdurchlauf der Anwendung war es wichtig, die gemachten Praxiserfahrungen der User*innen zu dokumentieren und zu analysieren, um sinnvolle Verbesserungen der Anwendung zu gewährleisten und die Benutzer*innenfreundlichkeit hierdurch noch zu erhöhen. So werden die gemachten Beobachtungen der Betreuer*innen in einem Buch gesammelt. Und User*innen werden nach dem Durchgang des Audiowalks über ein persönlich geführtes Gespräch nach der gemachten Erfahrung befragt, die über einen Fragenkatalog mit vorbestimmten Bewertungskriterien von 1 (schlecht) bis 5 (sehr gut) abgehakt werden. Des Weiteren werden Verbesserungsvorschläge niedergeschrieben und Punkte aufgelistet, an denen die User*innen auf Schwierigkeiten bei der Nutzung gestoßen sind. Diese werden dann analysiert und dienen als Grundlage für Verbesserungen.

Erfahrungen

Die Entwicklung einer Augmented Reality (AR) Anwendung im Museum bietet eine Vielzahl von Lerneffekten für alle Beteiligten. Hier sind einige Aspekte, die bei der Entwicklung einer solchen Anwendung berücksichtigt werden sollten:

Klassisches Denken im Hinblick auf den Content: Bei der Entwicklung einer AR-Anwendung im Museum ist es wichtig, den klassischen Inhalt des Museums zu berücksichtigen. Es geht darum, die traditionelle Ausstellung oder Sammlung zu erweitern und den Besucher*innen ein erweitertes und interaktives Erlebnis zu bieten. Das bedeutet, dass man den vorhandenen Content analysiert und überlegt, wie er durch AR-Elemente bereichert werden kann, um ein tieferes Verständnis und eine intensivere Erfahrung zu ermöglichen.

Iteratives Vorgehen und regelmäßige Prüfung: Die Entwicklung einer AR-Anwendung im Museum erfordert ein iteratives Vorgehen. Das bedeutet, dass man immer wieder Zwischenstände überprüft und auf Basis des Feedbacks Anpassungen vornimmt. Es ist wichtig, die Anwendung regelmäßig zu testen, um sicherzustellen, dass sie den gewünschten Effekt erzielt und den Erwartungen der Besucher*innen entspricht. Durch diesen iterativen Prozess kann man kontinuierlich verbessern und die AR-Erfahrung optimieren.

Vermeidung schneller technologischer Lösungen: Bei der Entwicklung einer AR-Anwendung im Museum sollte man sich nicht nur auf schnelle technologische Lösungen konzentrieren. Es geht nicht nur darum, die neueste Technologie zu nutzen, sondern auch darum, den Fokus auf den pädagogischen Wert und die nachhaltige Integration der AR-Elemente zu legen. Es ist wichtig, dass die technologischen Lösungen sorgfältig ausgewählt werden, um die bestmögliche Benutzer*innenerfahrung und den größtmöglichen Lernerfolg zu erzielen.