k:eva – Kultur-Evaluierungstool für (digitale) Angebote von Museen

Überblick

Wie auch viele andere Museen sendet die Klassik Stiftung Weimar (KSW) besonders seit Beginn der Corona-Pandemie Online-Vermittlungsangebote in den digitalen Raum. Über das Online-Publikum, das solche Angebote wahrnimmt, ist in den Institutionen jedoch meist relativ wenig bekannt. Um die Gelingensbedingungen von digitalen Angeboten zu erforschen, entwickelte die KSW ein neues Tool, das über die Ansätze bisheriger Fragebögen und Datenanalyse-Tools hinausgeht. Zusammen mit einer Agentur wurde in einem iterativen Vorgehen ein digitales Evaluierungstool entwickelt, um mit quantitativen, aber vor allem auch qualitativen Forschungsansätzen, mehr über das digitale Publikum und seine Interessen und Bedürfnisse herauszufinden. Dies wurde exemplarisch am Format der Digitalen Werkstatt erprobt. Im Entwicklungsprozess war es ein zentrales Anliegen, die Befragungen kurzweiliger und abwechslungsreicher zu gestalten und das Evaluierungs-Tool den vielfältigen Angeboten der KSW anzupassen. Die Einbindung in die tägliche Arbeit von Museen und anderen Kulturinstitutionen soll durch eine einfache Bedienung gefördert werden. Das k:evatool soll es ermöglichen kurze Umfragen zu vielfältigen Angeboten ohne großen Aufwand durchzuführen, schnell auszuwerten und somit Evaluierungsprozesse in das Tagegeschäft integrieren.

Bibliographische Angaben

- Institution

- Klassik Stiftung Weimar

- Teilprojekt

- Labor digital: Vermittlungsformate in und außerhalb der Museen

- Autor*innen

- Nicolas Dittgen

- Lizenz der Publikation

- CC BY 4.0

- Kontakt

- Nicolas Dittgen

Klassik Stiftung Weimar

+49(3643) 545564

bildung@klassik-stiftung.de

Entwicklung

Ausgangspunkt für die Entwicklung des Evaluierungstools ist die zunehmende Anzahl von Online-Angeboten der Klassik Stiftung Weimar. Über die Gelingensbedingungen solcher digitalen Vermittlungsformate ist wenig bekannt. Videos werden von Kolleg*innen gedreht, geschnitten und dann in den digitalen Raum gesendet. Über die konkrete Nutzung der Formate oder wer unsere Nutzer*innen oder digitalen Besucher*innen sind, wissen wir jedoch wenig. Mit der Schließung der Museen im März 2020 wurden die Institutionen vor neue Herausforderungen gestellt. So wurde das analoge Formate der offenen Besucher*innenwerkstätten zu Beginn der Corona-Pandemie digitalisiert und zur Digitalen Werkstatt weiterentwickelt. In kurzen Videos geben Museumspädagog*innen eine thematische Einordnung und bieten die Möglichkeit mit einfachen Materialien etwas selbst herzustellen. Ausgehend von diesem Beispiel wurde ein Evaluierungstool entwickelt, um mehr über die digitalen Besucher*innen dieses Angebots zu erfahren.

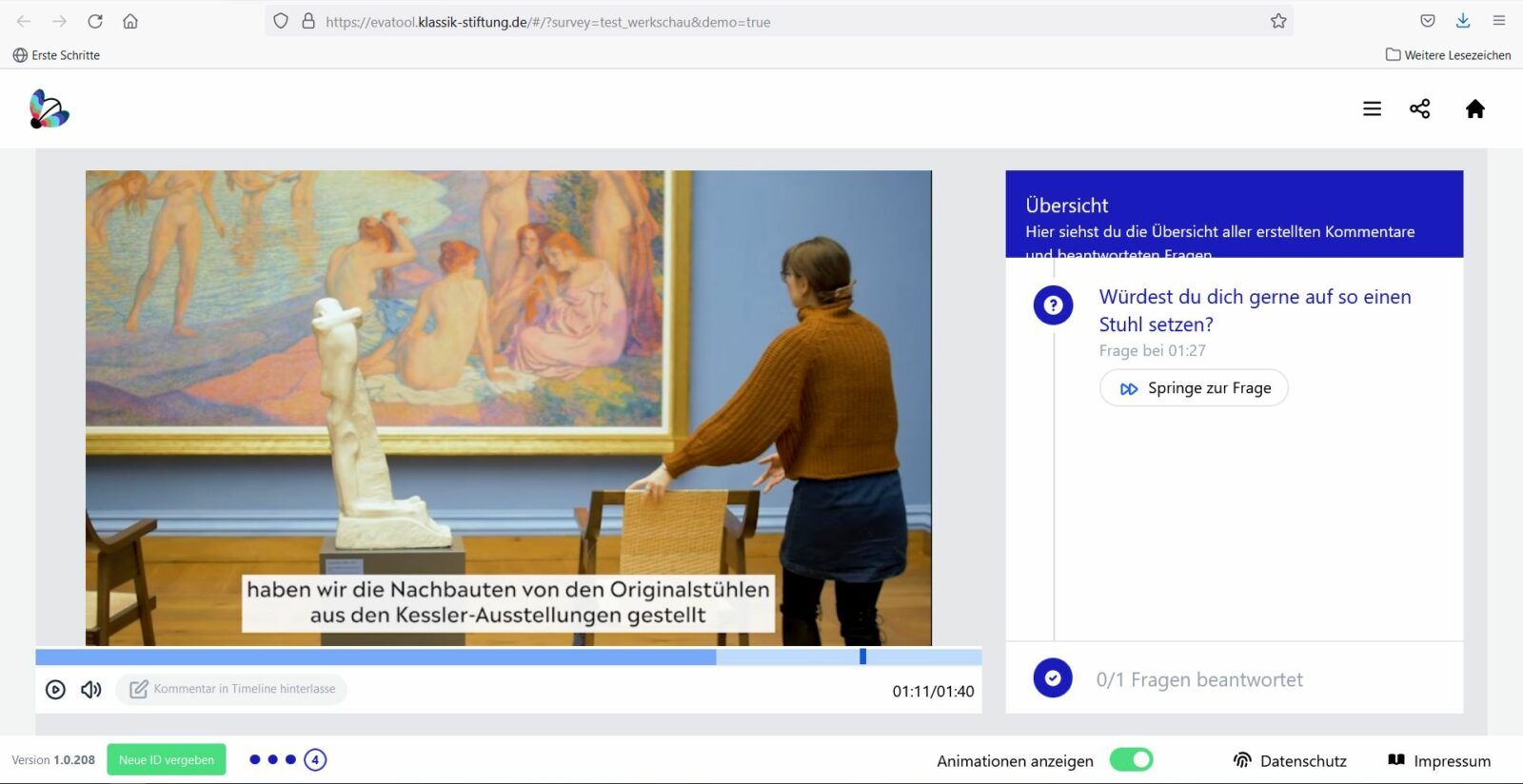

Zwar nutzt die KSW die gängigen Analysetools im Kontext der digitalen Besucher*innenforschung, wertet Klickzahlen, Geoinformationen und durchschnittliche Besuchszeiten aus. Konkrete Aussagen zur Wirksamkeit und Wahrnehmung eines Formats lassen sich durch diese Daten jedoch nur bedingt treffen. Am Anfang der Entwicklung stand daher eine Marktanalyse der bisherigen Evaluierungs-Tools, eine Evaluierung des Ist-Stands der Digitalen Werkstatt. Bei der Entwicklung eines Anforderungskatalogs stellte sich in erster Linie die Frage, über welche Funktionen das neue Evaluierungstool verfügen sollte. Für die Evaluation der Videos der „Digitalen Werkstatt“ sollten die Zuschauer*innen nicht nur summativ am Ende, sondern bereits während des Videos befragt werden können. Außerdem sollten Zuschauer*innen die Möglichkeit haben, während des Videos Feedback und Kommentare zu hinterlassen. Um dies möglichst spontan erfassen zu können, wurde die Form des Audiofeedbacks integriert.

Inhaltliches Konzept

Das k:evatool ist für die Evaluation vielfältiger, digitaler Vermittlungsformate konzipiert. Neben bewährten Umfrageformaten wie Multiple-Choice, Bewertungsskalen und Freitext ermöglicht das k:evatool auch die Erhebung von Daten im Kontext eines Videos. Ein zentraler Ansatzpunkt für das neue Evaluierungstool war, die Umfragen auf das Videoformat der Digitalen Werkstatt (Videoangebot der KSW) bzw. Videoformate an sich, zuzuschneiden. Dafür werden die Fragen als Zeitschritte im Videoplayer integriert. Hierbei können die Benutzer*innen an jeder Stelle im Video einen entsprechenden Kommentar verfassen. Zudem können an definierten Zeitpositionen innerhalb des Videos Fragen gestellt werden.

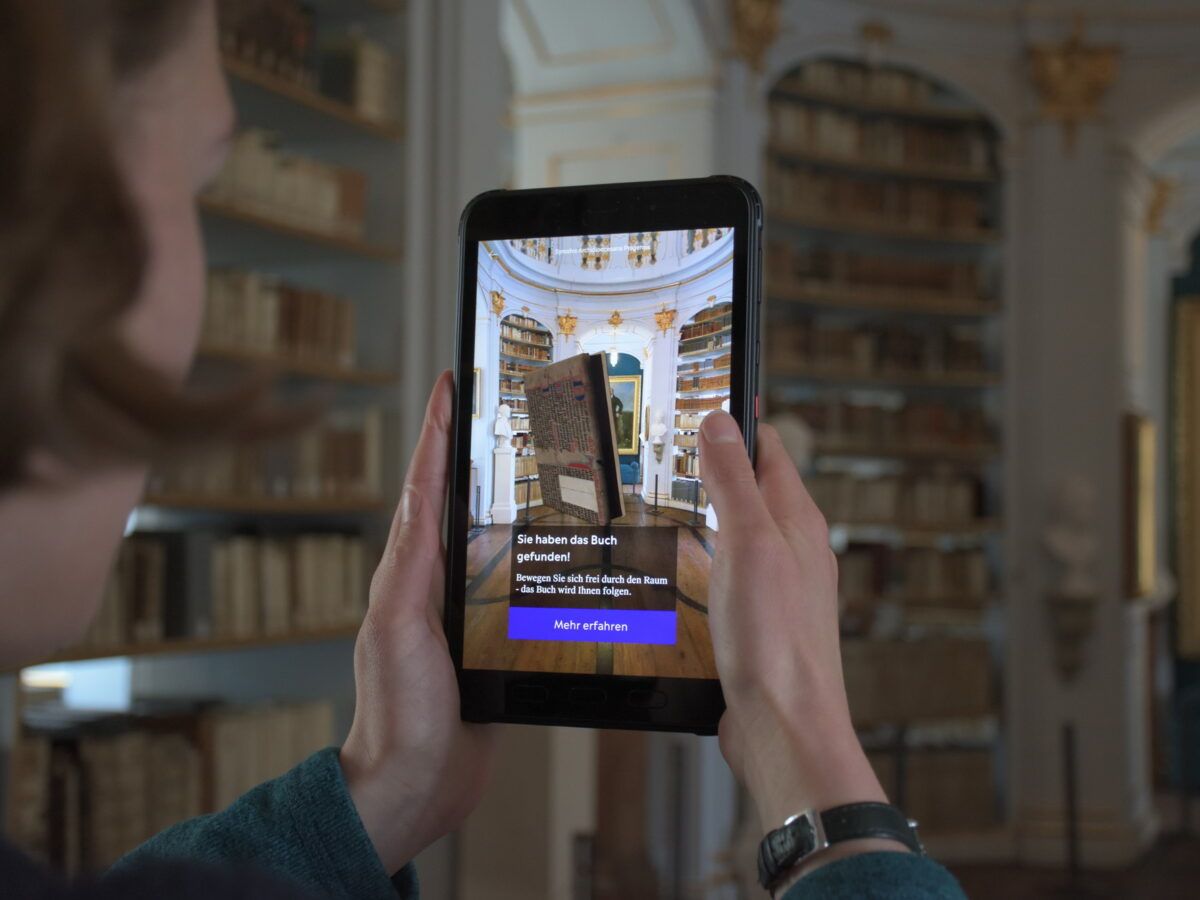

Eine weitere Besonderheit ist die eingebaute Schnittstelle, die es ermöglicht das k:evatool an die digitalen Angebote der KSW auf der Website oder der Weimar+ App anzupassen. Über die Rendered API können Umfragen komplett ausgespielt und in die anderen Anwendungen integriert werden. Befragte müssen so nicht mehr auf eine externe Website umgeleitet werden.

Außerdem sollten die Fragen der Umfrage nicht monoton, erwartbar und dadurch „langweilig“ ablaufen, wie es in vielen anderen Umfragen üblich ist. Daher wurden neue Arten von Frage- und Antwortmöglichkeiten für das Tool entwickelt. Dabei stand eine Orientierung an der alltäglichen Lebenswelt der befragten Nutzer*innen im Vordergrund. Ein Beispiel hierfür war eine „Sterne-Bewertung“ als Skala, die bspw. aus dem Kontext des Online-Shopping bekannt ist. Ferner wurde die „Wischfunktion“ integriert, um Zustimmung oder Ablehnung mitzuteilen, was vor allem aus einer Dating-App bekannt ist, sowie die Möglichkeit Sprachnachrichten wie in einem Messenger-Dienst aufzunehmen, um eine Frage zu beantworten. Die Option des Audiofeedbacks kann an allen Stellen einer Umfrage integriert werden. Das Format „Voicerecording“ bietet eine moderne und komfortable Alternative zur klassischen Texteingabe per Tastatur. Über einen optionalen Speech-To-Text-Service können die Audioaufnahmen im Anschluss entsprechend in analysierbaren Text umgewandelt, oder im Nachgang individuell transkribiert werden. Ein solcher Speech-To-Text-Anbieter kann durch einen Drittanbieter bereitgestellt und in das k:evatool integriert werden. Hier muss jedoch noch einmal besonders der Datenschutz berücksichtigt werden, da die Audioaufnahmen damit den eigenen Server verlassen. Dies ist vor allem relevant, da ansonsten das Tool und alle Daten auf den eigenen Servern gehostet werden können, was in Bezug auf Datenschutz für viele öffentliche Institutionen vorteilhaft sein kann. Eine Editierfunktion des Audiofeedbacks wurde in Hinblick auf die Spontanität der Antworten bewusst nicht integriert, Antworten können jedoch wieder gelöscht werden.

Durch all diese Maßnahmen soll die Hemmschwelle, an einer Umfrage teilzunehmen, und die Abbruchquote gesenkt werden.

Technisches Konzept

Alle Elemente des Evaluierungstools werden über das Content Management System verwaltet. Der Datenexport in verschiedene Dateiformate ist möglich. Über die Erweiterung um eine Rendered API ist eine Ausspielung einzelner Fragen (im Vergleich zur Ausspielung einer gesamten Umfrage) möglich. Dabei wird die jeweilige Frage inkl. Layout und Funktionalität (HTML, CSS, Javascript) ausgeliefert. Eine Einbindung in HTML-Iframe oder WebView (iOS & Android) ist möglich.

Die Corporate-Design-Vorgaben der KSW dienten als Basis für die Gestaltung des Evaluationstools. Über den iterativen Gestaltungsprozess wurden die einzelnen Komponenten entworfen. Vom kleinsten Grafikelement bis zum gesamten Erscheinungsbild ist alles in einem modernen und anpassbaren Stil gehalten, der auch die Regeln der barrierefreien Gestaltung einhält. Dazu wurden farbliche Abstufungen und Kontraste geprüft, sowie ausreichend Platz für die Darstellung interaktiver und stationärer Elemente gelassen. Für die Nachnutzung können das Logo sowie die CI Farben in der Konfigurationsdatei ausgetauscht werden.

Begonnen wurde der Entwicklungsprozess des k:evatools mit der Besucheransicht der Videoauswertung. Die Herausforderung war es, zeitbasiert Fragen an die Besucher*innen richten zu können, gleichzeitig aber auch den Prozess umzukehren und den Besucher*innen die Möglichkeit zu geben, zu jedem Zeitpunkt im Video Feedback geben zu können. Über zahlreiche unterschiedliche Wireframes und deren Test entstand ein immer funktionaler werdendes Design. Die Videoansicht wurde an vorderste Stelle geschoben, ein prominentes Modul zum Verfassen textuellen Feedbacks darunter angeordnet und in einem Widget auf der rechten Seite der allgemeine Fortschritt einsehbar gemacht. Obendrein besteht die Komplexität des Interfacedesigns beim Evaluationstool auch in der responsiven Gestaltung. Im nächsten Schritt wurden alle entwickelten Regeln und Funktionsweisen bei unterschiedlichen Screengrößen und Formaten getestet. Gerade die Nutzung eines modulartigen Aufbaus war hier entscheidend und so konnten alle Elemente bei der mobilen Variante untereinander angeordnet werden. Erst nach Sicherstellung der Funktionalität und Beibehaltung der Ästhetik wurden finale Screendesigns gebaut und zum internen Feedback weitergegeben. Nun begann der nächste Abschnitt des iterativen Prozesses, in dem noch mehr Personen die Gestaltung sehen, testen und Feedback geben konnten. Problematiken wie die Überfrachtung des Fortschritt-Widgets wurden so identifiziert und die Gestaltung entsprechend angepasst. Klarere Ikonografien, weniger Funktionsbuttons und ein Fortschrittszähler führten hier zum Erfolg.

Damit war ein wichtiger Schritt abgeschlossen und alle weiteren Bausteine konnten nach denselben Richtlinien gestaltet und das Evaluationstool so visuell ausformuliert werden. Alle weiteren Screendesigns durchliefen denselben, iterativen Gestaltungsprozess.

Um eine Umfrage im k:evatool zu erstellen, ist vom Administrator ein Benutzerzugang anzulegen. Mit den Zugangsdaten lässt sich die Editieransicht in einem Webbrowser öffnen. Die Editieransicht ermöglicht das Erstellen von Umfragen, sowie die Verwaltung von Videos, die evaluiert werden sollen oder Bilder, die in eine Frage integriert werden sollen. Darüber hinaus können dort Auswertungen betrachtet werden. Um eine Umfrage zu erstellen, muss zunächst definiert werden, in welcher/n Sprache(n) diese veröffentlicht werden soll. Im zweiten Schritt kann die Umfrage aus einzelnen Elementen erstellt und eine Abfolge der Umfrageschritte festgelegt werden. Für Elemente, die in mehrsprachige Umfragen integriert werden, sind zwingend auch die Übersetzungen ins System einzutragen, da die Umfragen sonst nicht durchführbar sind. Einmal angelegte Umfrage-Elemente können wiederverwendet werden. Muss ein Umfrage-Element geändert werden, wenn bereits Umfrage-Ergebnisse vorhanden sind, so erstellt das k:evatool eine Kopie des Umfrage-Elements, um Problemen bei der internen Auswertung vorzubeugen.

Alle Ergebnisse der Umfrage können über den Menüpunkt „Auswertungen“ abgerufen werden.

Die erhobenen Umfragedaten können in unterschiedliche Formate exportiert werden. Hier bieten sich vor allem zwei Formate an. Excel ermöglicht die Auswertung tabellarisch aufbereiteter Daten in Abfolge der Antworten von Benutzer*innen. Pro Zeile wird ein* Benutzer*in dargestellt. JSON ist ein roher „Datendump“, der zur Weiterverarbeitung in einer speziellen Software eingespielt wird und in dieser Form daher nur für Fachkundige brauchbar ist. Im JSON-Export sind sowohl Fragen als auch Antworten der Umfrage in einzelnen logischen Objekten enthalten.

Des Weiteren können die Daten visualisiert als Balkendiagramm betrachtet und im .png Format heruntergeladen werden. Werden Fragen geändert, nachdem in einer Umfrage bereits Ergebnisse gesammelt wurden, erstellt das Tool Kopien.

Nachnutzung und Weiterentwicklung

In Hinblick auf die Nachnutzbarkeit wurde das k:evatool so programmiert, dass Corporate Farben sowie das Logo der nachnutzenden Institution einfach angepasst werden können.

Das zentrale nachnutzbare Element ist das Evaluierungstool selbst, da es auf den eigenen jeweiligen Servern aufgesetzt werden kann. Die Programmierung wurde so umgesetzt, dass der Code möglichst verständlich und leicht anpassbar ist. Es wurde bei der Entwicklung versucht, keine komplizierte, womöglich später unverständliche, Wege zu gehen. Das Evaluierungstool verfügt über ein Content Management System (CMS), das eine einfache Anwendung des Tools ermöglicht. Es gibt verschiedene Frage- und Antworttypen, die ausgewählt und kombiniert werden können. Das Tool verfügt auch über die Möglichkeit, die Umfragen direkt im Tool auszuwerten. Die KSW hat für die Nachnutzung eine Rendered API beauftragt. Diese ermöglicht das Evaluierungstool flexibler zu nutzen und in andere digitale Anwendungen einzubinden, um bestimmte Angebote zu evaluieren.

Besucherforschung und Usability Tests

Es wurden immer wieder interne Umfragen angelegt und an Kolleg*innen der KSW geschickt, damit diese den aktuellen Stand des Evaluierungstools testen können. Auch im Rahmen von Museum4punkt0 wurde das Evaluierungstool vorgestellt und zum Testen der Anwendung eingeladen. Einige Museen haben einen Testzugang erhalten und eigene Umfragen angelegt. Des Weiteren haben auch Studierende der HS Heilbronn das Tool getestet, um eine Evaluierung durchzuführen. In der letzten Entwicklungsphase wurde eine Umfrage der Abteilung Kommunikation und Öffentlichkeit zu Besucher*innen im Museum Neues Weimar und im Bauhaus Museum umgesetzt.

Evaluierung

Als Startpunkt für die Entwicklung des Tools erstellte die KSW eine Testumfrage, die Fragestellungen und Erkenntnissinteressen verdeutlicht. An den Anforderungen dieser Umfrage orientierte sich die Konzeption des k:evatools. Dabei war das primäre Ziel nicht, eine quantitative wissenschaftliche Umfrage zu schaffen. Vielmehr ist das Ziel des k:evatools, Tendenzen für Gelingens- und Nutzungsfaktoren aufzudecken und genauer zu betrachten. Dabei wurden auch qualitative Forschungsansätze und Herangehensweisen verfolgt. Eine erste Befragung zur »Digitalen Werkstatt« wurde bereits unabhängig von der Entwicklung des k:evatools unter Beteiligten der Digitalen Werkstatt durchgeführt. Die Ergebnisse lagen vor. Hieraus wurde jedoch vor allem klar, dass das Angebot aktuell nur wenige Menschen erreicht und das Potential weiter ausgeschöpft werden muss.

Es wurden weiterhin zwei Evaluierungen in Kooperation mit Kulturmanagement-Studierenden der Hochschule Heilbronn unter Leitung von Frau Prof. Dr. Raphaela Henze durchgeführt. In einer ersten Evaluation haben sich die Studierenden mit der Digitalen Werkstatt auseinandergesetzt. Hierfür haben sie eines der klassischen Befragungstools („LamaPoll“) genutzt. Damit konnten sie einen Datensatz aus 154 abgeschlossenen Umfragen erstellen. Daraus entwickelten sie Empfehlungen für zukünftige Online-Videoformate der KSW. In einem zweiten Projektteil haben die Studierenden den Prototypen des neuen Evaluierungstools untersucht. In einer Umfrage über das Umfragetool im Umfragetool – auf einer Metaebene sozusagen – konnten 314 Teilnehmer*innen ihre Meinung und ihr Feedback geben.

Erfahrungen

Die Erfahrungen lassen sich in zwei Bereiche aufteilen: Erstens die Erfahrungen innerhalb der Anwender*innenseite und zweitens die Erfahrungen der Nutzer*innen in unseren Testphasen.

Für die Nutzung des Evaluierungstools muss auch intern geworben werden. Die Idee ist, das alle Mitarbeitenden ihre Projekte mit dem neuen Evaluierungstool kontinuierlich und auf einer niedrigschwelligen Ebene evaluieren können. Das Thema Evaluierung sollte bei allen Projekten von vornherein in der Konzeption und Planung bedacht werden. Durch das übersichtliche CMS und die intuitive Handhabung des k:evatools sollen alle Kolleg*innen die Möglichkeit bekommen Evaluierungsprozesse, inklusive dem Anlegen einer Umfrage und der Auswertung, umsetzen zu können. Inhalte und Fragestellungen einer Umfrage müssen jedoch weiterhin in Abhängigkeit von Projekt und Erkenntnisinteresse jeweils selbst konzipiert werden. Das Tool liefert keine vorgefertigten Fragen, da diese immer spezifisch ausformuliert werden müssen. Dabei stellt sich auch für eine Institution wie die Klassik Stiftung Weimar die Frage, wie Projekte langfristig integriert werden können. Bei einem Drittmittelprojekt tritt nicht selten der Fall ein, dass die beteiligten Mitarbeiter*innen im Anschluss nicht mehr am Haus tätig sind.

In der Testphase mit Nutzer*innen durch Testgruppen und Kooperationspartner*innen konnten umfangreiche Erfahrungen in der Anwendung des k:evatools gemacht werden.

Mit der Umfrage der Studierenden der HS Heilbronn und eigenen Tests wurde beispielsweise festgestellt, dass für die Verwendung der Spracheingabe ein Vertrauensverhältnis zur jeweiligen Institution notwendig ist. Daraus schließen wir, dass sich der Einsatz dieses Features bei Fokusgruppen oder im Nachgang an ein Projekt, Workshop oder eine Führung besser anbietet. Die Tests haben auch gezeigt, dass Umfragen möglichst kurzgehalten sein sollten. Im Idealfall sollten sie nicht länger als 5-7 Minuten dauern. In unserem Testlauf kam heraus, dass ein Interesse am Thema und die Unterstützung der jeweiligen Institution für die befragten Personen der Hauptmotivationsgrund war an einer Umfrage teilzunehmen. Die Möglichkeit im Anschluss an eine Umfrage etwas zu gewinnen, wird von den Befragten nur als geringer Motivationsgrund genannt. Die Ergebnisse der Studierenden sind in der Abschlusspräsentation dokumentiert, die ebenfalls im Anhang zur Verfügung steht.

Anhang

- Checkliste

- Leitfaden

- Abschlusspräsentation von Melina Egler, Annika Götz, Jana Ruoff & Lisa Schmidt der Fakultät TW/BK aus dem WiSe 2021/22

- Fragebogen – Digitale Werkstatt

- Fragebogen – Eva Tool

Der Code des k:evatools wird über GitHub bereitgestellt.

- k_evatool_laravel_package

- k_evatool_laravel_container_app

- k_evatool_survey_player

- k_evatool_admin_frontend